撰文|何聆筝编辑|翟文婷

黄仁勋需要花一点时间向全世界解释:为什么客户要为过剩的算力支付溢价?

从年初的CES到本次GTC大会,他一直在兜售「买越多,赚越多」的论调。他的逻辑是:AI将因为推理能力而扩容,所以客户对高性能计算资源存在确定性需求。技术迭代与成本下降的「杰文斯悖论」是又一重佐证。借着 2025 年GTC的演讲台,黄仁勋还回应了外界的诸多疑虑:算力是否真的已经见顶?技术护城河是否还在?「堆算力」的商业模式是否可持续?这些努力似乎收效甚微,市场没有积极回应。甚至在黄仁勋19号演讲结束后,英伟达的股价还下跌了3.4%。这也是黄仁勋第一次无法自主选择演讲议题。 过去一年,英伟达经历了多重冲击。地缘政治风云迭起,竞争对手虎视眈眈,叠加DeepSeek引发的算力需求「真假之辩」,自2024年7月至2025年3月,英伟达股价累计涨幅仅1.13%,远低于此前16个月432.44%的涨幅。AI 正在成为中美重要创新所在,作为AI水电生意的重要参与者、全球科技含量最高的公司,英伟达却屡受质疑。黄仁勋是一个善于从不确定性中汲取能量的领导者。他不戴手表,不设5年~10年的长期计划,创立英伟达30余年,先后多次带领公司穿越低谷。在拥抱不确定的过程中,黄仁勋也在不断地创造确定性。只是如今,英伟达的叙事逻辑需要全面更新。「皮衣刀客」年过花甲,还需再战。

过去一年,英伟达经历了多重冲击。地缘政治风云迭起,竞争对手虎视眈眈,叠加DeepSeek引发的算力需求「真假之辩」,自2024年7月至2025年3月,英伟达股价累计涨幅仅1.13%,远低于此前16个月432.44%的涨幅。AI 正在成为中美重要创新所在,作为AI水电生意的重要参与者、全球科技含量最高的公司,英伟达却屡受质疑。黄仁勋是一个善于从不确定性中汲取能量的领导者。他不戴手表,不设5年~10年的长期计划,创立英伟达30余年,先后多次带领公司穿越低谷。在拥抱不确定的过程中,黄仁勋也在不断地创造确定性。只是如今,英伟达的叙事逻辑需要全面更新。「皮衣刀客」年过花甲,还需再战。

AI工厂的操作系统

「100倍。」这是黄仁勋对未来AI推理算力需求的预测。相对于行业所预测的「5-10倍」,多出了一个数量级。为了论证自己的观点,在 3 月19号GTC大会演讲中,黄仁勋现场展示了一场AI模型对决——用Meta的Llama开源模型与DeepSeek-R1推理模型,解决一个复杂的婚礼座次安排问题。Llama迅速给出答案,生成了439个token,但答案是错误的。R1回答正确,但计算时间更长,共生成了8,559个token。他还晒出了一组数据,2024年美国前四云厂总计采购130万颗Hopper架构芯片,到了2025年,这一数据飙升至360万颗Blackwell GPU。黄仁勋的结论是,虽然优化技术可以提高AI计算效率,计算资源消耗减少,但整体需求仍将持续增长,Scaling Law依旧有效。遗憾的是,「过去这一年,几乎整个世界在这方面都看走眼了」。

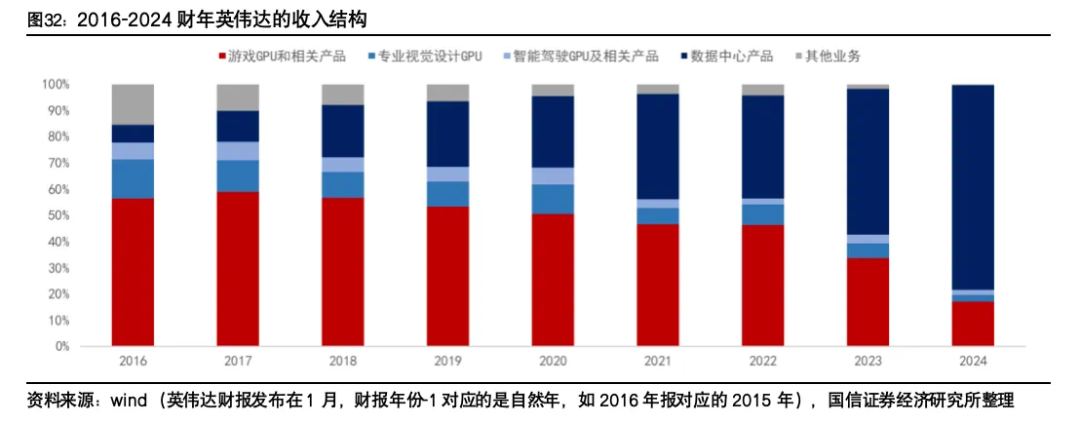

市场对推理算力需求的低估,给英伟达带来一连串的负面反应。首先是微软、谷歌等贡献英伟达40%收入的核心客户集体缩减高价GPU的采购订单,转而寻求成本更低的ASIC芯片或算法优化方案。比如微软的部分工作负载就转向了自研Maia芯片。虽然Blackwell仍占绝对优势,但客户的态度已经非常明显。DeepSeek的横空出世,给英伟达带来了另一场冲击。这家中国公司给予2048张H800芯片实现了接近GPT-o1的性能,推理成本仅为行业1/30「百万token输出2.2美元」,直接冲击英伟达高毛利率的H100和A100市场。坚如磐石的CUDA也因其开源生态而受到冲击。

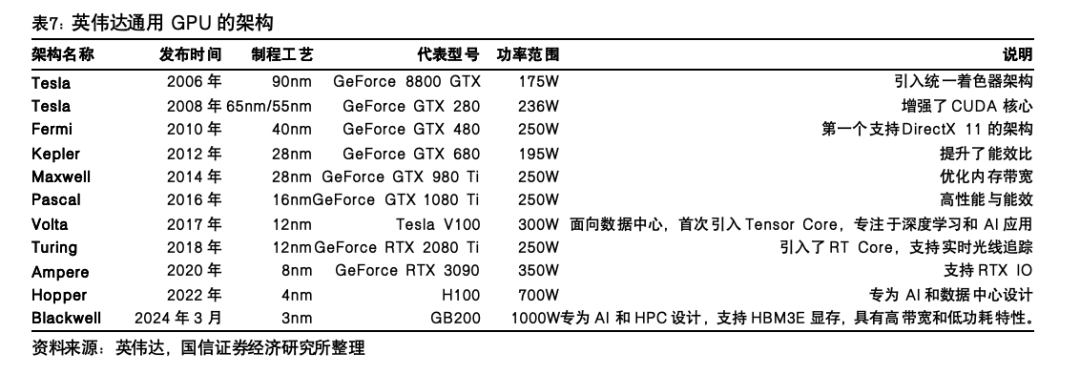

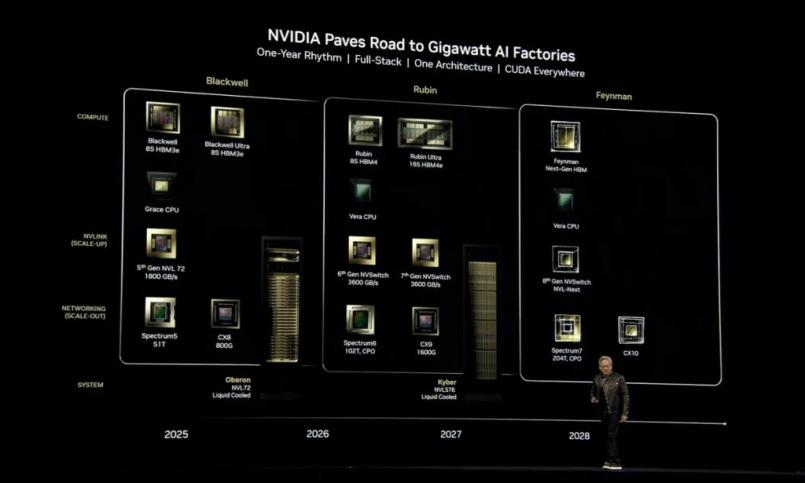

市场对推理算力需求的低估,给英伟达带来一连串的负面反应。首先是微软、谷歌等贡献英伟达40%收入的核心客户集体缩减高价GPU的采购订单,转而寻求成本更低的ASIC芯片或算法优化方案。比如微软的部分工作负载就转向了自研Maia芯片。虽然Blackwell仍占绝对优势,但客户的态度已经非常明显。DeepSeek的横空出世,给英伟达带来了另一场冲击。这家中国公司给予2048张H800芯片实现了接近GPT-o1的性能,推理成本仅为行业1/30「百万token输出2.2美元」,直接冲击英伟达高毛利率的H100和A100市场。坚如磐石的CUDA也因其开源生态而受到冲击。 基于种种,市场开始质疑英伟达的估值模型是否依旧成立。R1模型发布后,英伟达股价曾单日暴跌17%,市值蒸发5900亿美元。投资者的恐慌情绪一度蔓延至整个科技股,人们担心英伟达会走上思科的老路。明明AI是确定的未来,但是作为这条赛道最重要的玩家,英伟达却陷入巨大的不确定。黄仁勋的解法是:创造一个更大的「算力黑洞」。英伟达一边刺激需求爆炸性增长,一边降低AI算力的边际成本。比如专为「AI推理时代」打造的Blackwell Ultra超级芯片,在Dynamo、Grace Blackwell NVLink72超级芯片的加持下,相比Hopper可实现25倍的性能提升。而在推理模型中,Blackwell的性能是Hopper的40倍。在性能提升的同时,单位算力的成本也大幅下降。这便映衬了黄仁勋说的那句「买的越多,赚得越多」。如果还不满意,没关系,黄仁勋还一口气发布了未来三年的产品路线图。根据规划,2026年将推出全新Rubin架构的超级计算机柜Vera Rubin NVL144,而2027年还有更强的Rubin Ultra NVL576登场。这些新品在性能将视线跨越式提升。

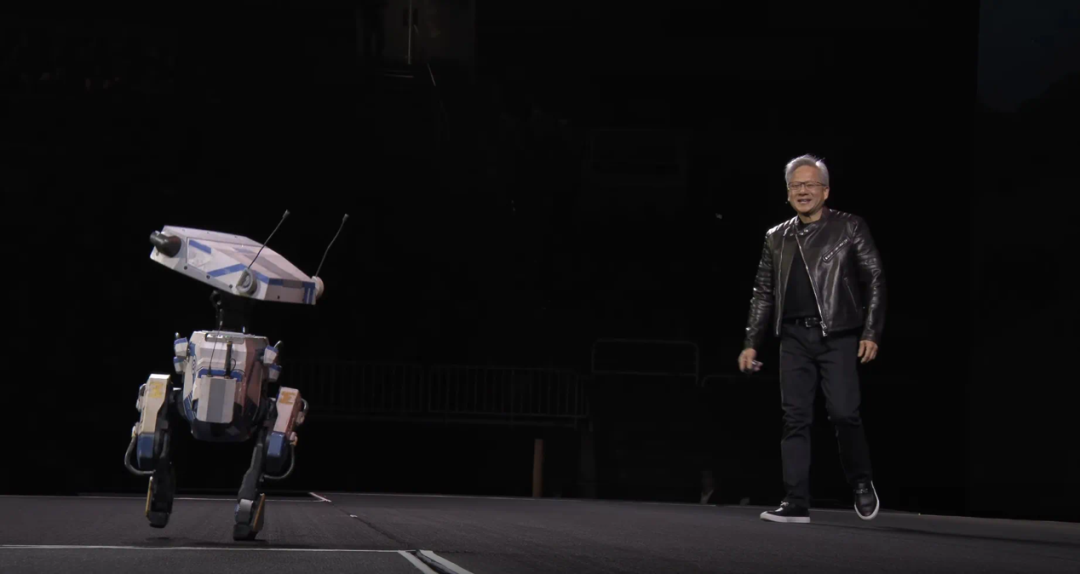

基于种种,市场开始质疑英伟达的估值模型是否依旧成立。R1模型发布后,英伟达股价曾单日暴跌17%,市值蒸发5900亿美元。投资者的恐慌情绪一度蔓延至整个科技股,人们担心英伟达会走上思科的老路。明明AI是确定的未来,但是作为这条赛道最重要的玩家,英伟达却陷入巨大的不确定。黄仁勋的解法是:创造一个更大的「算力黑洞」。英伟达一边刺激需求爆炸性增长,一边降低AI算力的边际成本。比如专为「AI推理时代」打造的Blackwell Ultra超级芯片,在Dynamo、Grace Blackwell NVLink72超级芯片的加持下,相比Hopper可实现25倍的性能提升。而在推理模型中,Blackwell的性能是Hopper的40倍。在性能提升的同时,单位算力的成本也大幅下降。这便映衬了黄仁勋说的那句「买的越多,赚得越多」。如果还不满意,没关系,黄仁勋还一口气发布了未来三年的产品路线图。根据规划,2026年将推出全新Rubin架构的超级计算机柜Vera Rubin NVL144,而2027年还有更强的Rubin Ultra NVL576登场。这些新品在性能将视线跨越式提升。 除此之外,黄仁勋还扔出王炸——Dynamo开源软件。在现有Hopper架构上,Dynamo可让标准Llama模型性能和营业收入翻倍。而对于DeepSeek等专门的推理模型,NVIDIA Dynamo的智能推理优化还能将每个GPU生成的token数量提升30倍以上,被黄仁勋描述为「AI工厂的操作系统」。Dynamo还主动兼容PyTorch、DeepSeek-R1等开源框架。看似开放,实则用英伟达的标准重新定义游戏规则。黄仁勋力图给世界勾勒一张确定的行动地图,那就是:AI越智能,就越需要买他们的芯片。实现AGI的底层燃料是算力,实现具身智能也需要算力,构建孪生宇宙Omniverse平台消耗的算力资源更是指数级增长。至于需要多少算力,黄仁勋给出了确定的数据——是过去的100倍。

除此之外,黄仁勋还扔出王炸——Dynamo开源软件。在现有Hopper架构上,Dynamo可让标准Llama模型性能和营业收入翻倍。而对于DeepSeek等专门的推理模型,NVIDIA Dynamo的智能推理优化还能将每个GPU生成的token数量提升30倍以上,被黄仁勋描述为「AI工厂的操作系统」。Dynamo还主动兼容PyTorch、DeepSeek-R1等开源框架。看似开放,实则用英伟达的标准重新定义游戏规则。黄仁勋力图给世界勾勒一张确定的行动地图,那就是:AI越智能,就越需要买他们的芯片。实现AGI的底层燃料是算力,实现具身智能也需要算力,构建孪生宇宙Omniverse平台消耗的算力资源更是指数级增长。至于需要多少算力,黄仁勋给出了确定的数据——是过去的100倍。

历史在押韵

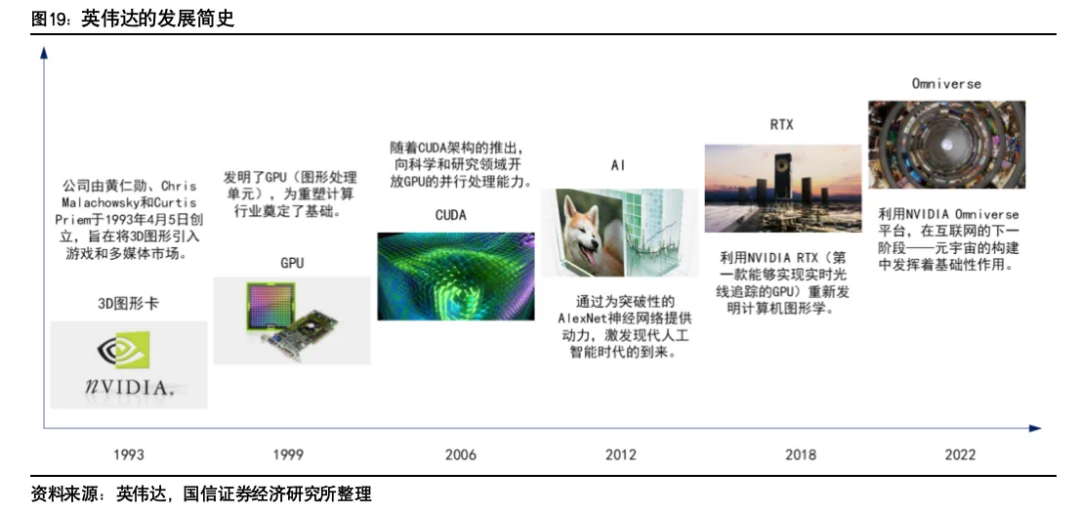

黄仁勋的演讲没能激起投资者的热情。相比起他规划的技术远景,市场更关注短期的收入能见度。《彭博社》评价道:缺少重磅利好消息,对股价造成压力。或许投资者更在意的是,61岁的黄仁勋是否还能像往日那样带领英伟达穿越周期?早年英伟达推出CUDA技术时,许多人都不能理解CUDA的价值,投资者把每年5亿美元的研发投入视为拖累盈利的「累赘」。

「显卡门」事件发生后,英伟达市值一度蒸发90%,当时华尔街对英伟达的技术和市场前景更加质疑,将CUDA的市场价值定义为「零」。但黄仁勋顶住压力,不仅没砍掉CUDA,还加倍投入。2010年,黄仁勋放弃手机市场,转而开拓自动驾驶与机器人技术领域时,市场同样是不理解的。许多投资者和分析师对英伟达的这一决定持怀疑态度,认为放弃快速增长的手机市场可能会影响公司的短期财务表现。毕竟当时英伟达凭借Tegra芯片已经在手机市场取得初步成功。押注CUDA,放弃手机市场,包括早期重力放在游戏显卡市场,黄仁勋始终热衷于选择「被忽视的小众领域」。这些充满不确定性的边缘市场因为低竞争和高潜力,也给英伟达带来了丰厚的回报和确定性优势。今天的黄仁勋,依然对具有高潜力的边缘市场秉持着确定性热情。比如这次GTC,黄仁勋展示了英伟达在机器人和量子计算领域的技术实力和市场布局。对新兴业务英伟达保持了高额的研发投入。他还预测2028年智算中心资本开支将超1万亿美元。只是过去的这种成功策略,对应战未来是否奏效?相比CUDA通过游戏显卡渗透计算市场的路径,如今,英伟达的商业化路径变长了,仅机器人业务就面临着硬件制造、场景落地、伦理监管等多重障碍。英伟达所面临的竞争环境也更加复杂。当年的竞争主要集中在GPU计算领域,而现在英伟达面临着来自多架构芯片、异构计算、软件生态、多领域应用拓展以及全球市场格局变化等多方面的挑战。还有不能忽视的一重因素是,英伟达当前市值超2.8万亿美元,在2024年营收1305亿美元的高基数下,市场还要求英伟达继续维持高增长,这与早年「小公司逆袭」的叙事逻辑全然不可同日而语。彼时,亏损可被解读为战略投入,而如今一点点增速放缓都会引发恐慌性抛售。

「显卡门」事件发生后,英伟达市值一度蒸发90%,当时华尔街对英伟达的技术和市场前景更加质疑,将CUDA的市场价值定义为「零」。但黄仁勋顶住压力,不仅没砍掉CUDA,还加倍投入。2010年,黄仁勋放弃手机市场,转而开拓自动驾驶与机器人技术领域时,市场同样是不理解的。许多投资者和分析师对英伟达的这一决定持怀疑态度,认为放弃快速增长的手机市场可能会影响公司的短期财务表现。毕竟当时英伟达凭借Tegra芯片已经在手机市场取得初步成功。押注CUDA,放弃手机市场,包括早期重力放在游戏显卡市场,黄仁勋始终热衷于选择「被忽视的小众领域」。这些充满不确定性的边缘市场因为低竞争和高潜力,也给英伟达带来了丰厚的回报和确定性优势。今天的黄仁勋,依然对具有高潜力的边缘市场秉持着确定性热情。比如这次GTC,黄仁勋展示了英伟达在机器人和量子计算领域的技术实力和市场布局。对新兴业务英伟达保持了高额的研发投入。他还预测2028年智算中心资本开支将超1万亿美元。只是过去的这种成功策略,对应战未来是否奏效?相比CUDA通过游戏显卡渗透计算市场的路径,如今,英伟达的商业化路径变长了,仅机器人业务就面临着硬件制造、场景落地、伦理监管等多重障碍。英伟达所面临的竞争环境也更加复杂。当年的竞争主要集中在GPU计算领域,而现在英伟达面临着来自多架构芯片、异构计算、软件生态、多领域应用拓展以及全球市场格局变化等多方面的挑战。还有不能忽视的一重因素是,英伟达当前市值超2.8万亿美元,在2024年营收1305亿美元的高基数下,市场还要求英伟达继续维持高增长,这与早年「小公司逆袭」的叙事逻辑全然不可同日而语。彼时,亏损可被解读为战略投入,而如今一点点增速放缓都会引发恐慌性抛售。 对英伟达而言,这是一次艰难的转身。除了更快的芯片,英伟达还需要塑造一套穿透技术周期的生存法则,一个更强、更新的资本逻辑作为叙事燃料。黄仁勋在GTC演讲中构建了「AI工厂」这个概念,他认为Token(大模型运行时的基本单位)会像农业时代的种子、工业时代的石油一样,成为AI时代最重要的生产要素来源。而英伟达正通过硬件、网络、软件等多方面技术创新,构建一个能够支持大规模AI生产的生态系统。黄仁勋想借此向外传递一个信息:英伟达的护城河并非只有芯片。但资本对此似乎还不准备买账。市场疑虑的是,deepseek所带来的示范可能会让AI公司转向算法优化,从而减少对高端芯片的依赖。而量子计算这些技术远景又难解近渴。

对英伟达而言,这是一次艰难的转身。除了更快的芯片,英伟达还需要塑造一套穿透技术周期的生存法则,一个更强、更新的资本逻辑作为叙事燃料。黄仁勋在GTC演讲中构建了「AI工厂」这个概念,他认为Token(大模型运行时的基本单位)会像农业时代的种子、工业时代的石油一样,成为AI时代最重要的生产要素来源。而英伟达正通过硬件、网络、软件等多方面技术创新,构建一个能够支持大规模AI生产的生态系统。黄仁勋想借此向外传递一个信息:英伟达的护城河并非只有芯片。但资本对此似乎还不准备买账。市场疑虑的是,deepseek所带来的示范可能会让AI公司转向算法优化,从而减少对高端芯片的依赖。而量子计算这些技术远景又难解近渴。

不确定和危机感

技术路径的确定性是否等于商业落地的确定性?对黄仁勋而言,这并不是一个一夜之间就能完全解答的问题。他正在努力给英伟达构筑多重「安全垫」。一方面,四代架构并行研发的策略,使竞争对手的追赶周期被拉长至12-18个月。另一方面,面对开源社区冲击,实施「开而不放」的生态战略,又将行业创新纳入自身技术轨道。比如Dynamo开源框架兼容了PyTorch、DeepSeek-R1等主流模型,通过智能调度将集群利用率从50%提升至92%,但核心功能仍锁定CUDA平台。技术上的领先,也使得意图「去英伟达化」的云厂商,依然处于「不得不买」的境地。毕竟Blackwell Ultra运行DeepSeekR1模型的效率是竞品的3倍,停用意味着客户流失。黄仁勋在演讲中就透露了,亚马逊AWS、微软Azure等四大云厂商购买了360万片Blackwell架构GPU的订单,这些订单的排期已经延续到2027年。英伟达还耗资了5000亿美元构建多区域产能网络,对冲全球化产能风险。该网络使英伟达能在24小时内切换全球70%的产能流向,例如中东AI算力集群订单激增时,可迅速调用越南基地的冗余产能。此外,英伟达在2025财年第四季度的自由现金流达到了155.19亿美元,这让英伟达有更充足的底气去收割长远的AI红利。

《英伟达之芯》的作者斯蒂芬·威特「Stephen Witt」曾在采访中被要求形容黄仁勋的特质。他用了四个字:凶猛、无情、负责、搞笑。排在前二的形容词似乎特别符合黄仁勋「算力暴君」的形象。他的员工可能感触更深,在英伟达,黄仁勋会责骂员工、冲人大吼,主张「失败必须被公开」。但如果再往前,隐隐浮现的却是一种不安全感。作为移民,黄仁勋在年少时曾因语言不通和文化差异遭受霸凌。对生存环境保持敏锐,或许是黄仁勋早年在逆境塑造的个性。时至今日,英伟达依然有「公司离破产只有30天」的戒律。但黄仁勋并非畏惧危机的保守派,相反,他信奉弱肉强食,对技术停滞的警惕远超同行,他提出「黄氏定律」,不遗余力地缩短架构周期,使竞争对手始终保持追赶。正如他的观点,「要么奔跑追逐食物,要么奔跑逃避成为食物。」在一个充满巨大不确定的领域,或许这是唯一可以确定的。

《英伟达之芯》的作者斯蒂芬·威特「Stephen Witt」曾在采访中被要求形容黄仁勋的特质。他用了四个字:凶猛、无情、负责、搞笑。排在前二的形容词似乎特别符合黄仁勋「算力暴君」的形象。他的员工可能感触更深,在英伟达,黄仁勋会责骂员工、冲人大吼,主张「失败必须被公开」。但如果再往前,隐隐浮现的却是一种不安全感。作为移民,黄仁勋在年少时曾因语言不通和文化差异遭受霸凌。对生存环境保持敏锐,或许是黄仁勋早年在逆境塑造的个性。时至今日,英伟达依然有「公司离破产只有30天」的戒律。但黄仁勋并非畏惧危机的保守派,相反,他信奉弱肉强食,对技术停滞的警惕远超同行,他提出「黄氏定律」,不遗余力地缩短架构周期,使竞争对手始终保持追赶。正如他的观点,「要么奔跑追逐食物,要么奔跑逃避成为食物。」在一个充满巨大不确定的领域,或许这是唯一可以确定的。